VMware NSX é a solução de virtualização de rede que reproduz um modelo inteiro de redes baseado em software, habilitando uma topologia de rede de forma simples com redes em níveis de multi-tier, além de oferecer a capacidade de provisionamento em segundos;

O NSX possibilita criar um modelo operacional subjacente da rede física;

O NSX oferece um modelo de implementação não disruptiva sobre qualquer rede física existente ou redes de próximas gerações;

|

| Figura 1: Conceito de topologia do NSX |

NSX oferece uma biblioteca completa de elementos lógicos de rede, como switches, routers, firewalls, load balancers, VPN e workloads de segurança.

|

| Figura 2: Biblioteca de recursos do NSX |

NSX também oferece uma fácil integração com soluções de rede e segurança de terceiros "third-party", através de APIs padrões.

Pré-requisitos do NSX:

- Physical network – VXLAN transport network, MTU;

- vCenter and ESXi 5.5;

- vSphere Distributed Switch;

Opções de Licencimento do NSX:

No NSX 6.2.2, a VMware introduziu 3 edições de licença diferentes:

Capacidades e Recursos NSX:

No NSX 6.2.2, a VMware introduziu 3 edições de licença diferentes:

- Standard Edition: automatiza os fluxos de trabalho de TI, agilizando a rede de data centers e reduzindo os custos operacionais da rede e sua complexidade.

- Advanced Edition: Standard Edition mais um centro de dados fundamentalmente mais seguro com micro-segmentação. Ajuda a proteger o data center aos níveis mais altos, ao mesmo tempo que automatiza o provisionamento de segurança de TI.

- Enterprise Edition: Advanced Edition, além de rede e segurança em vários domínios. Permite que a rede do centro de dados se estenda em vários sites e se conecte a cargas de trabalho físicas de alto débito.

- Recursos inclusos em cada licença:

|

| Figura 3: Lista de recursos de cada opção de licença do NSX |

Capacidades e Recursos NSX:

- O NSX Suporta:

- 1.000 Hosts

- 10.000 VMs

- 10.000 Port Groups

- 60.000 Virtual Ports

- NSX suporta múltiplos vDS no mesmo cluster;

- VMs são conectadas em redes isoladas com as VLANs;

Arquitetura do NSX:

- 1.000 Hosts

- 10.000 VMs

- 10.000 Port Groups

- 60.000 Virtual Ports

NSX consiste de 3 níveis de operação:

- Data Plane

- Control Plane

- Management Plane

|

| Figura 5: Níveis de Operação do NSX |

Detalhamento do Data Plane:

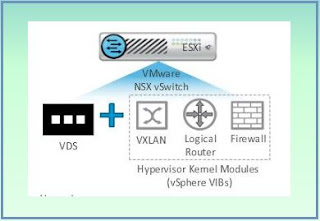

- Recursos do Data Plane: Distributed Services: VXLAN, Logical Router, Firewall, NSX Edge Gateway Services e NSX Virtual Switch;

- O NSX instala 3(três) vSphere Instalation bundles (VIBs) para habilitar as funcionalidades do NSX:

- O Primeiro VIB habilita a camada 2, virtual extensible local área network (VXLAN)

- O Segundo VIB habilita o Router Distribuído (DLR)

- O Terceiro VIB habilita o Firewall Distribuído

|

| Figura 6: Recursos do Data Plane |

- Depois que os VIBs são instalados, o vDS se torna um VMware NSX Virtual Switch;

- NSX Edge Gateway não é distribuído e por isso precisa de uma entidade de controle;

- Conceitualmente um NSX Edge pode ser uma barreira entre o Data e Control Plane;

- NSX vSwitch prove access-level switching no hypervisor

- NSX inclui built-in serviços de segurança como:

- Distributed Firewall east-west layer 2 para layer 4 traffic;

- Edge Firewall para tráego north-south;

- Spoofguard para validação de IP/MAC identity;

- Extensible Frameworks:

- Antivírus/Antimalware e Anti-boot Solutions;

- Layer 7 Firewall;

- Host e Network Based IPS/IDS Services;

- File Integraty Monitoring;

- Vulnerability Management of Guest VMs;

- NSX prove built-in network and Edge Services incluindo:

- Logical Router;

- Load Balancing - (layer 4 até layer 7) duas opções: [ Inline Mode e Proxy Mode]

- L2/3 VPN Services;

- Edge Firewalling (ESG);

- DHCP/NAT;

NSX Edge prove um ponto centralizado de comunicação e integração com a rede física para prover a comunicação com as redes externas. (Trafégo Norte Sul);

Detalhamento do Control Plane:

O NSX control plane roda no VMware Controller Cluster;

- Recursos do Control Plane: NSX Controller e NSX Logical Router Control VM e User Word Agent;

- Gerencia as redes lógicas;

- NSX logical router control VM e o VMware NSX Controller são VMs que são implantadas pelo NSX Manager no Control Plane;

- O Logical router control VM lida com a relação das rede de roteamento;

- NSX virtual Switch não controla o plano de controle de tráfego;

- Um NSX Controller VM implementa cada router distribuído por instancia;

- NSX Controller instance retem a informação de MAC, ARP e VTEP tables;

- Recomendado implementar NSX Controller em um cluster com 3 VMs;

- Se os componentes do Control Plane são perdidos, a habilidade de formar novos caminhos entre VMs será perdida;

Os hosts do controlador NSX são implementados como appliances virtuais a partir do gerenciador NSX. Cada appliance comunica através de um endereço IP distinto. Embora muitas vezes localizados na mesma sub-rede que o gerenciador NSX, isso não é uma exigência rígida;

Cada appliance deve respeitar estritamente as especificações:

|

| Figura 8: Recursos necessários para configuração do Controller |

Recomenda-se efetuar a implantação de nós de cluster em hosts ESXi separados. Com isso garantem que a falha de um único host não cause a perda de um número maioritário no cluster. NSX não aplica nativamente esta prática de design.

Logical Router Control VM:

- Prove o roteamento do control plane que permite o encaminhamento local dentro dos hosts, além do roteamento dinamico entre os hosts e o roteamento norte-sul provido pelo Edge.

|

| Figura 9: Logical Router Control VM |

UWA - User Word Agent:

- O UWA interpoe-se entre o NSX Controller e os módulos kernel hypervisor, exceto o módulo de firewall Distribuido.

- O NSX manager prove a instalação do NSX hypervisor Kernel e o User word Agent;

- O User Word Agent (UWA) é composto dos daemons no ESXi: ntcpad e vsfwd

- A comunicação entre o NSX Manager e o NSX Controller e os hosts ESXi acontece através de UWA (usa SSL para essa comunicação)

Management Plane:

- Recursos do Management Plane: NSX Manager, vCenter Server e Message Bus Agent;

- NSX Manager é a gerencia de redes centralizada do VMware NSX que é conectado ao vCenter Server;

- NSX Manager prove configuração e orquestração de serviços funcionais como switches lógicos, routing, e firewall distribuido;

- NSX Manager prove um sistema agregado com oNSX Manager vSphere Plug-in;

|

| Figura 12: Recursos do Management Plane |

Integração e gerenciamento com as soluções de Terceiros (Palo Alto, Trend, McAfee, Symantec e Rapid7)

- NSX Manager comunica com o vCenter Server para o management plane

- NSX Manager é a interface do VMware NSX API

- NSX Manager instace implementa o NSX Controller Instances

Componentes do NSX:

Recursos do NSX:

Automation:

- NSX integra com vRealize Automation para incluir um REST API aberto. Permitindo uma customização fora da caixa;

- NSX prove elasticity criando redes lógicas que podem atravessar a o DC inteiro;

- Prove a segurança permitindo completo isolamento de segmentos de rede;

- Permite também um firewall granular permitindo a integração com firewall de terceiros;

- Prove um gerenciamento centralizado dos serviços de rede virtualizados, como routing, switching, e firewall;

- NSX integra com vRealize Automation;

Limites de Escala do NSX para vSphere:

- NSX Manager e vCenter Server systems estão conectados em uma proporção 1:1, e o NSX Controller Cluster são implantados pelo NSX Manager. Em adição para o vSphere vMotion boudaries.

- VMware NSX for vSphere habilita conectividade de camada 2 que usa VXLAN para abrangir o vCenter inteiro;

- LIFs ( logical Interfaces)

- UWA (User World Agent)

- VNI (Vxlan Number Identifier)

- VIBs ( vSphere Installation Bundles)

Virtual Switch:

Virtual Switch é similar a um switch fisico

- Habilitam a criação de tráfego de redes isoladas;

- Reduz a desordem da rede;

- Realizam as seguintes funções:

- Validam cada frame (MAC de destino) quando chegam;

- Encaminham o frame para uma ou mais portas;

- Evitam as entregas desnecessárias;

A conexão entre uma VM e um switch virtual e similar a conexão entre um computador fisico e e um switch fisico.

Os uplinks são os adaptadores de rede físico encontrados no host ESXi utilizados para conectar ao switch fisico;

VSS - vSphere Standard Switch:

|

| Figura 16: Conceito do VSS |

- Podem encaminhar o tráfego internamente entre as VM nos mesmos grupos de portas e o link para as redes externas;

- Podem ser utilizada para combinar a banda de múltiplos adaptadores de rede e balanceia a comunicação do tráfego entre eles;

- O número default de portas lógicas para uma switch standard é de 120;

- Pode-se conectar um adaptador de rede de cada VM para cada porta;

- Cada adaptador de uplink associa com uma porta do switch standard;

- A instalação do host ESXi cria um switch standard default denominado vSwitch0;

- VSS Consiste de:

- Port Groups

- VMKernel ports

- Uplink Ports

|

| Figura 17: Conexões do VSS |

- VMKernel Port é uma porta de um switch virtual para qual a vNIC é conectada;

- Esta Virtual NIC é usada pelo host ESXi prover os serviços no nível do kernel;

|

| Figura 18: vmKernel |

- VSS Suporta:

- Layer 2 Forwarding

- VLAN

- Link Aggregation

- Port Security

- NIC Teaming

- Limitações:

- Não é muito escalável porque cada um desses vSwitches é colocado para um host ESXi particular e cada vSwitch é gerenciada individualmente;

|

| Figura 19: Distribuição das conexões do VSS |

- Prove uma interface centralizada o qual pode-se configurar, monitorar e administrar as VMS através do DC inteiro;

- Prove uma configuração simplificada, melhora o monitoramento e o troubleshooting

- VDS expande sobre o modelo de VSS para prover um gerenciamento centralizado

|

| Figura 21: Distribuição ds conexões do VDS |

- VDS abstrai o management plane para o data plane e é configurado e gerenciado centralmente através do vCenter Server;

- Um switch proxy é automaticamente criado em cada host ESXi quando o VDS é anexado ao host.

- Todos os movimentos do dados acontecem através dos hosts ESXi, mas a configuração e gerenciamento é feito através do vCenter Server;

- A configuração é automaticamente propagada para cada host ESXI que é anexado ao VDS

|

| Figura 22: VDS |

VDS suporta recursos avançados como:

- Network I/O Control

- QoS

- Traffic Monitoring

- Multicast Filtering

Limitações:

- Uma distributed port group é tipicamente associado com uma vlan na rede física, esta associação entre a rede virtual e física torna difícil a automação por inteira;

- Redes fim a fim em camada 2. Uma nova vlan em um port group requer configuração manual para rede física;

Logical Switch

- Encapsula o tráfego da VM para usar VXLAN ou STT - Stateless Transport Tunneling protocols

- Hosts físicos podem ser provisionados usando VMware vSphere auto Deploy com suporte a DHCP Relay e Helper;

- Cada vCenter Server instance pode suportar:

- Suporta até 128 vDS e cada vDS pode gerenciar até 500 hosts;

Vantagens de Switches Lógicos:

- Permite a infraestrutura de later 2 sobre layer 3;

- Prove 10.000 segmentos lógicos.

VXLAN: (Virtual Extensive LAN)

- Permite criar uma rede lógica para as VMs através de diferentes redes.

- VXLAN é uma tecnologia de Ethernet over IP, onde o frame original é encapsulado em um pacote UDP e entregue sobre uma rede de transporte, esta tecnologia prove a habilidade de estender a rede layer 2 através dos limites de layer 3 e consomem capacidade através de clusters.

- O MTU requirido é o minimo de 1600 bytes para suportar IPv4 e IPv6;

- O tráfego é encapsulado e exposto para o cabeçalho VXLAN pelo Virtual Tunnel end Point (VTEP);

- Expande o número de segmentos lógicos de 4094 para mais de 16 milhões.

- ID da VXLAN é conhecido como VNI (VXLAN NETWORK IDENTIFIER)

- Aparece transparente para as VMs;

- Adiciona 50 bytes ao frame original;

- Benefícios:

- Escalável mutitenance através do DC;

- Habilidade para habilitar infraestrutura L2 sobre L3;

- Switches Lógicos span across de hosts físicos e switches de rede;

- VXLAN consiste de:

- VTEP: VXLAN Tunnel end Point

- VTEP é uma interface VMKernel que encapsula o frame Ethernet original com o cabeçalho VXLAN

- A função do VTEP é encapsular o tráfego da VM dentro de um IP header para senviar através de uma rede IP.

- NSX oferece funcionalidade Hardware VTEP com vários parceiros

- Hardware VTEP em contexto com VMware NSX referencia switches fisicas ou roteadores com capacidade de VXLAN

- É uma entidade que encapsula o frame ethernet em um VXLAN Frame ou expõe um VXLAN frame e encaminha o Frame Etherne

- É o VMkernel interface que serve como um endpoint para encapsular o trafego ou expor o trafego VXLAN

- Não suporta fragmentação

- Usando VTEP o VXLAN aumenta a escalabilidade de componentes de rede.

- Cada rede VXLAN é uma rede logica isolada

- Transporte Zone define o membro ou VTEPS de cada VXLAN overlay pode incluir ESXi hosts de diferentes VMware vSphere Clusters;

- Um único cluster pode ser parte de múltiplas transport zones;

- VXLAN Frame Walk

- VM1 envia o quadro(frame) l2 para o VTEP local;

- VTEP adiciona o VXLAN, UDP e IP header;

- Transporte fisico encaminha como um pacote IP regular;

- Destination Hypervisor VTEP de-sencapsula o Frame;

- L2 Frame encaminha para a VM2;

- VXLAN Overlay Tunnel:

- Quando VMs em diferentes hosts se comunicam, um VXLAN overlay é estabelecido entre VTEP em ambos os hosts;

- VTEP Proxy:

- É um VTEP que encaminha o tráfego VXLAN do segmento local para outro VTEP em um segmento remoto. É usado em Unicast Tunnel End Point (UTEP) e multicast Tunnel End Poit (MTEP)

- VXLAN Number Identifier:

- VNI é 24-bit number que é adicionado ao quadro VXLAN;

- VNI único identifica o segmento para qual interno ethernet frame pertence;

- Múltiplos VNIs podem existir no mesmo trasporte zone;

- NSX for vSphere inicia com VNI 5000;

- VXLAN Protocol:

- Configura limites de overlay em transporte entre os hosts ESXi;

- Transport Zone:

- Todos os clusters da mesma transporte zone compartilha a mesma VNI

- Um transporte Zone pode conter múltiplos clusters e um cluster pode ser parte de múltiplos transport zones

- VXLAN replication modes:

- Relata o manuseio de Unicast, Hybrid e Multicast Traffic;

- Unicast:

- Todo o tráfego é replicado pelo VTEP;

- No mesmo segmento o trafego é replicado pelo VTEP de origem;

- Em um segmento de VXLAN remoto o NSX controller instace seleciona o proxy VTEP;

- Hybrido:

- É uma replicação local que e descarregada na rede física e faz replicação remota através de unicast;

- Hybrid mode usa IGMP layer 2 multicast para descarregar a replicação local para a rede física;

- Replicação remota usa proxies unicast, assim multicast routing não é necessário;

- Multicast:

- Requer IGMP para a topologia de camada 2 e multicasting routing para a topologia de camada 3;

- Multicast é visto frequentemente em cenários de upgrade de VMware vCloud Networking e Security;

Logical Router:

- DLR Distributed routing do NSX previne Hairpinning, provendo funções de Hypervisor no nível de roteamento, se uma VM que esta rodando em um hypervisor que esta conectada em diferentes subnets, a comunicação entre essas VMs é feita pelo router;

- A suíte de protocolos TCP/IP, oferece diferentes protocolos de roteamento que prove um roteador com métodos para construir roteadores válidos;

- DLR Control VM:

- DLR control VM é componente do control plane;

- Estabelece as sessões do protocolo de roteamento;

- DLR control VM não é o caminho do dado;

- Comunica com NSX Manager e envia routing updates para o VMware NSX Controller cluster;

- Tem um firewall instalado no DLR control VM, porem é extritamente usado para proteger o DLR control VM;

- Para evitar um único ponto de falha, deve-ser configurar o DLR control VM no modo Active/Standby;

- O módulo Kernel tem o RIB que é conhecido como routing table;

- O Data Plane atua como Route lookup ou ARP entry lookup são atribuidos pelo módulos do kernel;

- A camada de redes é responsável por routing, forwarding, contolling e sequencing dos pacotes;

- DLR router em camada 3 data inclui:

- Logical interface (LIF)

- As interfaces lógicas, conhecidas como LIFs, são configuradas em roteadores lógicos. Eles são análogos às interfaces virtuais comutadas ou interfaces fisicas na infra-estrutura de rede tradicional. Os endereços IP são atribuídos a LIFs e pode haver vários LIFs por DLR. Quando um LIF é configurado, ele é distribuído para todos os outros hosts. Uma tabela ARP também é criada e mantida para cada LIF.

- O Módulo Kernel são equipados com LIFs;

- Uma LIF conecta a um switch lógico e tem um único IP;

- DLR inclui a LIF o qual conecta aos switches lógicos ou port groups;

- Máximo de 1000 LIFs podem ser configurados;

- Possui uma tabela ARP e os IPs são assinados para as LIFs de cada segmento;

- Virtual Media Access Control (vMAC)

- vMAC é o MAC address da LIF;

- VMs usam o MAC associado com a LIF para acessar o default gateway;

- Quando uma VM envia um ARP request, o vMAC é usado;

- Porque o vMAC das VMs não é armazenado na tabela MAC do switch físico, os hosts rodando na instancia DLR envia o vMAC de cada LIF para as VMs em um switch lógico;

- Physical MAC (pMAC)

- pMAC é o MAC do uplink o qual o tráfego do switch segue para a interface física

- Na interface do DLR para um Distributed port Group, o router pode comunicar com a entidade física, usando o MAC address de origem, isso permite o switch fisico ver o pMAC e ter o pMAC na tabela MAC;

- Layer 2 Bridging:

- L2 Bridge entre o switch lógico e uma VLAN, habilita migrar a carga de trabalho virtual para o dispositivo fisico;

- VXLAN para VLAN Bridge habilita a conectividade entre as VMs em um distributed port group, essa conectividade é chamada de layer 2 bridging.

- A conectividade ethernet pode ser extendida para dispositivos físicos assinando um uplink para o distributed port group;

- L2 bridging habilita a VM em switch lógico para acessar a rede física;

- L2 bridging é usado para:

- Habilitar a migração física para virtual (P2V) sem mudar o IP;

- Extende o serviço virtual em um switch lógico para devices externos;

- Extende os serviços de rede física para VMs em switches lógicos

- Acessa a rede física existente em switches lógicos;

- L2 Bridge não deve ser usado para:

- Conectividade entre VXLAN para VXLAN;

- Data center interconnect;

- OSPF:

- Version 2;

- Backbone Area e NSSA support;

- Clear Text e MD5 peer authentication;

- DR e BRD interface support;

- Hello interval e dead interval configuration;

- Priority for DR e BDR election;

- Interface cost configuration;

- Area Border Router - ABR:

- Conecta um ou mais OSPF areas com a backbone network;

- Mantém uma copia individual do link-state database na memoria para cara área conectada;

- Autonomous System Boundary Router - ASBR

- Conecta roteadores que pertencem a outras áreas usando static routing ou outros protocolos de roteamento como IS-IS em adição ao OSPF;

- Distribui rotas descobertas de um sistema externo para outro OSPF enabled Router;

- Internal Router:

- É um OSPF-enable router que pertence somente a uma área e tem vizinho somente dentro da área;

- OSPF AREAS:

- É uma coleção de roteadores, links e redes que tem a mesma identificação de área;

- Cada router OSPF combina com outras áreas e forma um backbone área;

- Backbone área combina múltiplas e independentes áreas dentro de um domínio logico e tem o ID como (0);

- Principal responsabilidade é distribuir routing information entre non-backbone áreas;

- Quando é habilitado o OSPF a área 0 e 51 são criadas por default;

- Default área do NSX é a área 51 o qual pode ser deletada e reconfigurada com a área desejada;

- 3 tipos de áreas:

- Normal

- Stub

- Not-so-Stub area (NSSA)

- Cada área mantem uma database separada;

- Stub áreas são áreas que não recebem route advertismentes external para o AS;

- NSA são áreas stub que podem importar AS external routes e envia-las para outras areas;

- OSFP AS (Autonomous System)

- Conhecido como dominio de roteamento;

- Inclui todos os roteadores que rodam OSPF e trocam link-state information com cada router;

- Cada router interface que esta participando do processo OSPF é colocado na area;

- IS-IS

- Inter-domain Routing Protocol;

- Tem o design similar ao OSPF;

- Roda sobre camada 2 e suporta múltiplos routed protocols;

- Suporta um grande dominios de roteamento e oferece router área e interface level support;

- Router level support:

- Envolve a configuração de Área ID

- System ID

- IS Type - Level 1-2,

- Dominios passwords

- Área password

- Area-Level Support:

- Até 3 IP address por area

- Amplo range de niveis de interface

- Interface-Level Support:

- vNIC Name

- Hello timer

- Hello Multiplier

- Metric

- Priority

- Circuit Type

- LSP Level

- Mesh Group

- Password

- IS-IS AREAS:

- Usa 2 niveis de hierarquia oara gerenciar, escalar grandes redes

- Um dominio é e particionado em 2 areas - Level 1 e Level 2

- Similar a OSPF, associa routers para areas e identifica as areas usando numeros

- Level 1 Areas são equivalentes a area normal no OSPF, non-backbone ares

- Level 2 Areas são similares a Backbone ares do OSPF

- BGP

- RFC 4271;

- Recursos:

- iBGP e eBGP support;

- Router-level Configuration;

- Local AS to route packets to other AS;

- Neighbor-Level configuration;

Edge Services Gateway:

- Edge Routing/NAT

- Static Routing;

- Dynamic routing protocol;

- Redistribution;

- Suporte 2 modos:

- Active/standby;

- ECMP mode;

- NAT:

- Suporte Source NAT

- Suporta Destiantion NAT

- Edge Firewall

- Suporta Stateful Firewalling

- Tráfego Leste Oeste

- Load Balancing

- L2/L3 VPN

- IPsec site-to-site Connectivity;

- SSL VPN Connectivity;

- DHCP/DNS Relay

- IP Address;

- Default GW;

- DNS Servers;

- Search Domain Parameters;

Logical Firewall:

- Edge Firewall ajuda a realizar parametros de segurança necessário para configurar DMZs, baseado em IP/VLAN;

- Tenant-to-Tenant isolation in multi-tenant virtual DC;

- NAT;

- Partner (Extranet) VPNS;

- User Based Secure Layer (SSL);

- Pode ser usado como:

- NSX Edge Firewall:

- É focado no tráfego norte-sul ou um tenant ou como firewall de perimetro do DC;

- Firewall Distribuído:

- É focado no tráfego leste-oeste;

- É um hypervisor Kernel-embedded firewall;

- Prove um hypervisor baseado na aplicação em cada vNIC;

- Suporta regras de segurança, conhecidas como policy rules das camads 2,3 4 e 7;

- É independente do Router Distribuido;

Logical Load Balancer:

- Oferece distribuição de carga de trabalho através de múltiplos servers, assim como alta disponibilidade

- NSX prove load balancing até a camada 7;

- Load Balancer Modes:

- Layer 4 Load Balancing:

- É baseado em TCP;

- Pode ser habilitado usando a vCloud Network e Security APIs;

- Layer 4 mode usa somente DNAT e preserva o ip original do cliente;

- Layer 7 Load Balancing:

- É baseado em proxy;

- Ocorre na camada 7;

NSX Edge Gateway:

- Conecta redes Stub isoladas para compartilhar ou fazer uplink entre as redes;

- NSX Edge suporta OSPF, que roteia somente em um único domínio;

- NSX Edge Gateway prove integrada L3 para L7 services

- Edge Gateway atua como um virtual appliance e um modelo para prover a rápida implantação e scale-out e oferece os seguintes benefícios:

- Permite instalação de serviço em tempo real;

- Suporta dynamic service differentiation per tenant ou aplicação

- Utiliza a capacidade x86 dos computadores;

NSX Edge NAT:

- NSX Edge prove serviços de NAT para assinalar um endereço publico para um computador ou um grupo de computadores privados;

NSX Edge High Availability:

- Habilita o NSX Edge Appliance para estar sempre disponível, instalando um par ativo do NSX Edge Gateway em sua infraestrutura virtualizada;

- Pode habilitar o HA quando instala NSX Edge ou em uma instancia Edge Instalada;

- O NSX Edge primário fica no estado ativo e o segundo em standby;

- NSX Edge replica a configuração do appliance primário para o appliance secundário;

- Recomenda que crie o primário e secundário em recursos separados de pools e datastore;

- NSX Edge suporta várias VPNs que mede a segurança de dados entre VMs de diferentes locais;

Nenhum comentário:

Postar um comentário

Deixe seu comentário!